La habilidad de acceder y analizar grandes cantidades de datos se ha vuelto esencial. Web Scraping emerge como una técnica fundamental en este escenario, permitiendo a empresas, investigadores y desarrolladores extraer información valiosa de Internet de manera eficiente. Esta técnica no solo optimiza la recopilación de datos sino que también abre puertas a nuevas posibilidades en análisis y estrategias de negocio. Sin embargo, su uso viene acompañado de responsabilidades legales y éticas. Esta guía ofrece una visión detallada sobre qué es el Web Scraping, abordando sus técnicas, legalidad, y mejores prácticas, asegurando así un uso informado y responsable de esta poderosa herramienta.

¿Qué es el Web Scraping?

Web Scraping es una técnica avanzada utilizada para extraer grandes cantidades de datos de sitios web de manera automatizada. Esta práctica implica el uso de programas o scripts que simulan la navegación humana en Internet para recopilar información específica. A diferencia de la recopilación manual, que es tediosa y consume mucho tiempo, el Web Scraping permite obtener datos de manera eficiente y rápida, lo que lo convierte en una herramienta valiosa en la era del big data.

Una característica clave del Web Scraping es su versatilidad. Puede ser utilizado para una variedad de propósitos, desde el análisis competitivo y la investigación de mercado hasta la monitorización de redes sociales y la recopilación de datos para el aprendizaje automático. Al automatizar la extracción de datos, las empresas y los individuos pueden procesar y analizar grandes volúmenes de información, lo que facilita la toma de decisiones basadas en datos y la generación de insights valiosos.

Sin embargo, el Web Scraping también plantea desafíos técnicos y legales. El respeto por la propiedad intelectual y la privacidad de los datos es fundamental, y es crucial entender las leyes y regulaciones que rigen esta práctica. Además, los sitios web a menudo implementan medidas para prevenir el scraping, lo que requiere un enfoque sofisticado y respetuoso para su implementación.

Técnicas de Web Scraping

El mundo del Web Scraping es vasto, y las técnicas utilizadas para extraer datos de sitios web pueden variar significativamente en complejidad y sofisticación. Aquí se destacan algunas de las técnicas más comunes y eficaces:

Parsing HTML: Esta es la técnica más básica, donde se extraen datos directamente del código HTML de una página web. Utilizando bibliotecas específicas como BeautifulSoup en Python, los desarrolladores pueden seleccionar fácilmente los elementos específicos que desean extraer.

Automatización de Navegadores: Herramientas como Selenium permiten simular la navegación humana en un navegador web. Esta técnica es especialmente útil para interactuar con páginas web dinámicas que requieren interacciones del usuario, como hacer clic en botones o completar formularios.

APIs Web: Algunos sitios web ofrecen APIs públicas que permiten acceder a sus datos de manera estructurada y eficiente. Utilizar estas APIs es una forma de Web Scraping legal y eficiente, ya que se accede a los datos de la manera que el proveedor de la web ha previsto.

Extracción de Datos AJAX: Muchas páginas web modernas utilizan AJAX (Asynchronous JavaScript and XML) para cargar contenido dinámico. Las técnicas de scraping avanzadas pueden interceptar y extraer estos datos directamente de las solicitudes AJAX.

Manejo de Cookies y Sesiones: Para sitios que requieren autenticación o mantienen el estado del usuario, es esencial manejar cookies y sesiones para acceder efectivamente a los datos.

Web Scraping Headless: Utilizando navegadores sin interfaz gráfica (headless browsers), como Puppeteer con Node.js, se pueden realizar tareas de scraping en un entorno que imita un navegador real, pero sin la sobrecarga gráfica.

Cada una de estas técnicas tiene sus propias ventajas y desafíos, y la elección depende de la complejidad del sitio web objetivo y de los requisitos específicos del proyecto de scraping. Es crucial elegir la técnica adecuada para garantizar la eficiencia y el éxito del proceso de recopilación de datos.

Legalidad del Web Scraping

La legalidad del Web Scraping es un tema complejo que varía según la jurisdicción y el contenido específico de los sitios web. Aquí se presentan algunos aspectos clave a considerar:

Respeto a los Términos de Servicio: Muchos sitios web incluyen cláusulas sobre el scraping en sus términos de servicio. Ignorar estas cláusulas puede resultar en acciones legales. Es esencial leer y entender estos términos antes de iniciar cualquier actividad de scraping.

Derechos de Autor y Propiedad Intelectual: El contenido de un sitio web puede estar protegido por derechos de autor. Utilizar datos recopilados a través del scraping para propósitos comerciales sin permiso puede violar estas leyes.

Protección de Datos y Privacidad: En jurisdicciones con leyes estrictas de protección de datos, como el GDPR en Europa, es crucial asegurarse de que el scraping no infrinja la privacidad de los individuos. Recopilar y utilizar datos personales sin consentimiento puede tener graves consecuencias legales.

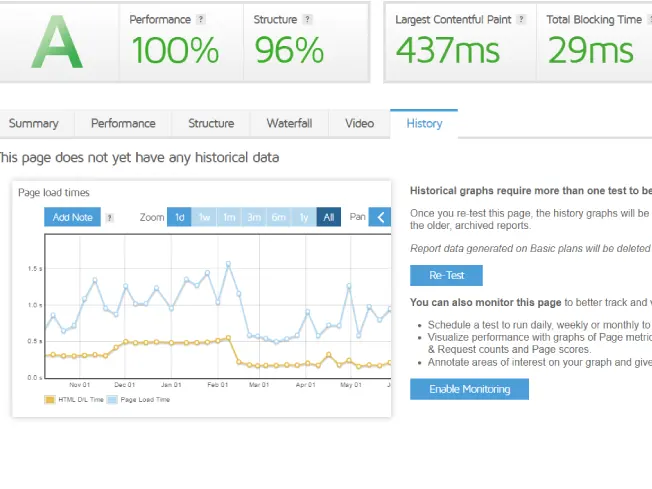

Prevención de Daños al Sitio Web: El scraping intensivo puede sobrecargar los servidores del sitio web, lo que podría interpretarse como un ataque de denegación de servicio. Es importante realizar scraping de manera responsable para evitar dañar o afectar el rendimiento del sitio web objetivo.

Uso de Datos Recopilados: Además de cómo se recopilan los datos, la forma en que se utilizan también es crucial desde el punto de vista legal. El uso indebido de datos, especialmente para fines engañosos o fraudulentos, puede llevar a acciones legales.

Es recomendable consultar con un experto legal para entender las implicancias específicas en el contexto de un proyecto de Web Scraping, especialmente si los datos van a ser utilizados para propósitos comerciales o publicados. Mantenerse informado y respetar las leyes y regulaciones es esencial para realizar Web Scraping de manera ética y legal.

¿Cómo realizar Web Scraping?

Realizar Web Scraping de manera efectiva implica varios pasos clave, cada uno con su propia importancia y desafíos. Aquí se describen las etapas fundamentales:

- Identificar la Fuente de Datos: El primer paso es seleccionar los sitios web de los cuales se desea extraer datos. Es crucial evaluar la estructura del sitio y la accesibilidad de los datos requeridos.

- Elegir la Herramienta Adecuada: Dependiendo de la complejidad del sitio web y de los datos a recopilar, se debe elegir la herramienta de scraping adecuada. Herramientas como BeautifulSoup, Scrapy para Python, o Selenium para tareas más complejas, son opciones comunes.

- Desarrollo del Script de Scraping: Crear un script que navegue por el sitio web, acceda a las páginas pertinentes y extraiga los datos deseados. Este paso requiere conocimientos de programación y comprensión de HTML, CSS, y posiblemente JavaScript.

- Manejar la Paginación y Navegación: Muchos sitios web distribuyen su contenido a través de múltiples páginas. Es importante diseñar el script para que pueda navegar por estas páginas de manera eficiente.

- Extraer y Almacenar Datos: Los datos recopilados deben ser extraídos en un formato utilizable y almacenados adecuadamente, generalmente en bases de datos o archivos como CSV o JSON.

- Respetar las Políticas de Robots.txt: Antes de realizar scraping, es esencial verificar el archivo robots.txt del sitio web, que indica las directrices sobre qué páginas pueden o no ser raspadas.

- Implementar Manejo de Errores y Retrasos: Para evitar sobrecargar el servidor del sitio web y manejar posibles errores, es importante incorporar retrasos entre las solicitudes y mecanismos de manejo de errores en el script de scraping.

- Pruebas y Mantenimiento: Una vez desarrollado el script, es necesario probarlo exhaustivamente para asegurar su correcto funcionamiento y realizar mantenimientos periódicos para adaptarse a los cambios en la estructura del sitio web.

Al seguir estos pasos, se puede realizar Web Scraping de una manera eficiente y respetuosa, asegurando la recopilación de datos de calidad sin infringir las normas legales o éticas.

¿Cómo funcionan las solicitudes web?

Entender cómo funcionan las solicitudes web es fundamental para realizar un Web Scraping efectivo. Esta comprensión ayuda a diseñar scripts más eficientes y a evitar problemas comunes. Aquí se detallan los aspectos clave:

Protocolo HTTP/HTTPS: Las solicitudes web se realizan generalmente a través de los protocolos HTTP o HTTPS. Estos protocolos son las reglas que definen cómo se envían y reciben los datos entre el cliente (navegador o script de scraping) y el servidor web.

Solicitudes y Respuestas: Una solicitud web (request) es un mensaje enviado por el cliente al servidor para solicitar acceso a una página web. El servidor responde con un mensaje de respuesta (response), que incluye el contenido de la página y metadatos relevantes.

Métodos de Solicitud: Existen varios métodos de solicitud, como GET para solicitar datos de un recurso específico y POST para enviar datos al servidor. El método utilizado dependerá del tipo de interacción que se desea realizar con el sitio web.

URLs y Parámetros: Las URLs son las direcciones web a las que se dirigen las solicitudes. Pueden incluir parámetros que especifican cierta información, como criterios de búsqueda o identificadores de páginas.

Cabeceras de Solicitud: Las solicitudes incluyen cabeceras que proporcionan información adicional al servidor, como el tipo de navegador, el idioma preferido, y a veces, detalles de autenticación.

Cookies y Sesiones: Las cookies son datos almacenados en el cliente que el servidor utiliza para reconocer solicitudes sucesivas de un mismo usuario. El manejo de cookies es esencial para acceder a contenido que requiere autenticación o mantener un estado en el sitio.

Manejo de Errores HTTP: Los códigos de estado HTTP (como 404 para «No encontrado» o 500 para «Error interno del servidor») son parte de la respuesta del servidor e indican el resultado de la solicitud. Comprender y manejar estos códigos es crucial para un scraping eficiente.

AJAX y Solicitudes Asíncronas: Las tecnologías AJAX permiten que se realicen solicitudes adicionales después de que se haya cargado la página inicial, usualmente para actualizar contenido dinámicamente. Capturar y manejar estas solicitudes puede ser clave para extraer datos de sitios web modernos.

Entender estos componentes de las solicitudes web permite a los desarrolladores de Web Scraping diseñar scripts que interactúen eficazmente con los sitios web, manejen adecuadamente los datos y respeten las buenas prácticas y la legalidad.

Herramientas de Web Scraping

Las herramientas de Web Scraping son fundamentales para extraer datos de la web de manera eficiente y automatizada. Existen diversas opciones, cada una adecuada para diferentes necesidades y niveles de habilidad. A continuación, se detallan algunas de las más destacadas:

BeautifulSoup: Una biblioteca de Python que facilita el análisis de documentos HTML y XML. Es ideal para proyectos sencillos y para quienes se inician en el Web Scraping, gracias a su simplicidad y facilidad de uso. BeautifulSoup

Scrapy: Otra poderosa herramienta de Python, más avanzada que BeautifulSoup. Scrapy es adecuada para proyectos de scraping a gran escala, proporcionando un marco completo que maneja solicitudes, seguimiento de enlaces y extracción de datos.

Selenium: Aunque originalmente diseñada para pruebas de software, Selenium es ampliamente utilizada en Web Scraping para interactuar con páginas web dinámicas. Permite controlar un navegador web, lo que es útil para sitios que requieren interacción del usuario o que utilizan mucho JavaScript.

Puppeteer: Una biblioteca para Node.js que proporciona una interfaz de alto nivel para controlar navegadores Chrome o Chromium. Es especialmente útil para sitios web modernos y ricos en JavaScript.

Octoparse: Una herramienta de scraping visual que no requiere programación. Permite a los usuarios crear tareas de scraping a través de una interfaz gráfica, lo que la hace accesible para usuarios no técnicos.

Import.io: Una plataforma basada en la nube que permite transformar páginas web en datos estructurados. Ofrece una interfaz intuitiva y es útil para quienes prefieren una solución menos técnica.

ParseHub: Similar a Octoparse, ofrece un enfoque visual para el Web Scraping. Posee capacidades avanzadas, como el manejo de sitios web con AJAX y JavaScript.

APIs de Web Scraping: Existen servicios que ofrecen APIs específicas para scraping, como ScraperAPI o WebHarvy, que simplifican el proceso al manejar internamente aspectos como la rotación de IP y el manejo de CAPTCHAs.

Herramientas Personalizadas: En algunos casos, desarrollar una herramienta personalizada puede ser la mejor opción, especialmente para necesidades específicas o integraciones complejas.

La elección de la herramienta adecuada depende de varios factores como la complejidad del sitio web, los requisitos de los datos, el volumen del scraping y el nivel de habilidad técnica del usuario. Experimentar con diferentes herramientas y plataformas puede ayudar a encontrar la solución más adecuada para cada proyecto de Web Scraping.

¿Cómo evitar el Web Scraping? – Estrategias y técnicas

Proteger un sitio web contra el Web Scraping no autorizado es crucial para salvaguardar la información y mantener la integridad del sitio. A continuación, se presentan estrategias efectivas para prevenir o minimizar el scraping no deseado:

Monitoreo de Tráfico: Vigilar constantemente el tráfico del sitio web puede ayudar a identificar patrones sospechosos o actividades anómalas que sugieran scraping. Herramientas de análisis web como Google Analytics pueden ser útiles para este propósito.

Bloqueo de Direcciones IP Sospechosas: Al detectar direcciones IP que realizan un número excesivo de solicitudes en un corto período, bloquearlas puede ser una medida efectiva. Sin embargo, es importante tener cuidado con los bloqueos para no afectar a usuarios legítimos.

Uso de CAPTCHAs: Implementar CAPTCHAs puede ayudar a prevenir el scraping automatizado, ya que requiere una intervención humana para continuar accediendo al sitio. Aunque no es infalible, aumenta la dificultad para los scrapers automáticos.

Limitación de Tasa de Solicitudes: Establecer límites en el número de solicitudes que un usuario puede hacer en un período de tiempo ayuda a prevenir el abuso del scraping. Esto puede ser especialmente efectivo contra herramientas de scraping que hacen muchas solicitudes en poco tiempo.

Autenticación de Usuarios: Requerir a los usuarios que inicien sesión para acceder a cierta información puede ser un obstáculo adicional para los scrapers. Esto también permite un control más detallado sobre quién accede a los datos.

Cambios en la Estructura del Sitio: Realizar cambios periódicos en la estructura del sitio web y en los nombres de las clases y los ID de los elementos puede desorientar a los scripts de scraping que dependen de una estructura específica.

Uso de Archivos Robots.txt: Aunque no es legalmente vinculante, un archivo robots.txt puede indicar a los bots de buena fe (incluidos algunos scrapers) qué partes del sitio no deben ser accedidas.

Técnicas de Ofuscación: Ofuscar el código HTML o usar técnicas como cargar datos importantes a través de scripts puede dificultar la extracción de información.

APIs con Límites de Uso: Ofrecer una API pública con límites claros y controlados en el acceso a los datos puede ser una alternativa para quienes necesitan datos de su sitio, disminuyendo la necesidad de scraping.

Asesoría Legal: En casos de scraping malintencionado que viole los términos de servicio, puede ser necesario recurrir a asesoría legal para emprender acciones contra los infractores.

Implementar una combinación de estas estrategias puede aumentar significativamente la protección contra el Web Scraping no autorizado, aunque es importante mantener un equilibrio para no afectar negativamente la experiencia del usuario legítimo.

Preguntas frecuentes

El mundo del Web Scraping puede ser complejo y lleno de matices. Aquí respondemos algunas de las preguntas más frecuentes para aclarar dudas y proporcionar una comprensión más profunda:

- ¿Es legal el Web Scraping?

- La legalidad del Web Scraping depende de múltiples factores, como las leyes del país, los términos y condiciones del sitio web y la naturaleza de los datos scrapeados. En general, es legal si se respetan los términos de servicio del sitio y las leyes de propiedad intelectual y privacidad de datos.

- La legalidad del Web Scraping depende de múltiples factores, como las leyes del país, los términos y condiciones del sitio web y la naturaleza de los datos scrapeados. En general, es legal si se respetan los términos de servicio del sitio y las leyes de propiedad intelectual y privacidad de datos.

- ¿Qué diferencias hay entre Web Scraping y Crawling?

- Web Scraping se refiere específicamente a la extracción de datos de sitios web, mientras que Web Crawling implica recorrer la web para indexar y organizar información, como lo hacen los motores de búsqueda.

- Web Scraping se refiere específicamente a la extracción de datos de sitios web, mientras que Web Crawling implica recorrer la web para indexar y organizar información, como lo hacen los motores de búsqueda.

- ¿Puedo hacer Web Scraping sin saber programar?

- Sí, existen herramientas como Octoparse y ParseHub que ofrecen interfaces gráficas para realizar Web Scraping sin necesidad de escribir código.

- Sí, existen herramientas como Octoparse y ParseHub que ofrecen interfaces gráficas para realizar Web Scraping sin necesidad de escribir código.

- ¿Cómo puedo evitar que mi sitio web sea scrapeado?

- Implementar medidas como CAPTCHAs, bloqueo de IP, limitación de tasa de solicitudes y autenticación de usuarios puede ayudar a proteger tu sitio contra scraping no deseado.

- Implementar medidas como CAPTCHAs, bloqueo de IP, limitación de tasa de solicitudes y autenticación de usuarios puede ayudar a proteger tu sitio contra scraping no deseado.

- ¿Qué lenguajes de programación son mejores para Web Scraping?

- Python es ampliamente reconocido por su eficiencia en Web Scraping, gracias a bibliotecas como BeautifulSoup y Scrapy. Sin embargo, otros lenguajes como JavaScript (con herramientas como Puppeteer) también son populares.

- Python es ampliamente reconocido por su eficiencia en Web Scraping, gracias a bibliotecas como BeautifulSoup y Scrapy. Sin embargo, otros lenguajes como JavaScript (con herramientas como Puppeteer) también son populares.

- ¿Es posible scrapear datos de sitios web dinámicos?

- Sí, sitios web dinámicos que utilizan mucho JavaScript pueden ser scrapeados usando herramientas como Selenium o Puppeteer que permiten la interacción con el sitio como lo haría un navegador.

- Sí, sitios web dinámicos que utilizan mucho JavaScript pueden ser scrapeados usando herramientas como Selenium o Puppeteer que permiten la interacción con el sitio como lo haría un navegador.

- ¿Cómo manejan los scrapers la paginación y el seguimiento de enlaces?

- Los scrapers avanzados pueden ser programados para seguir automáticamente enlaces y manejar la paginación, extrayendo datos de múltiples páginas de manera eficiente.

- Los scrapers avanzados pueden ser programados para seguir automáticamente enlaces y manejar la paginación, extrayendo datos de múltiples páginas de manera eficiente.

- ¿Qué retos se presentan al hacer Web Scraping a gran escala?

- Los retos incluyen manejar la rotación de IP para evitar bloqueos, el procesamiento y almacenamiento de grandes volúmenes de datos, y el mantenimiento de los scrapers ante cambios en los sitios web.

- Los retos incluyen manejar la rotación de IP para evitar bloqueos, el procesamiento y almacenamiento de grandes volúmenes de datos, y el mantenimiento de los scrapers ante cambios en los sitios web.

- ¿Qué hacer si los datos scrapeados no están estructurados?

- Herramientas de procesamiento de datos y técnicas de aprendizaje automático pueden ayudar a estructurar y analizar datos no estructurados extraídos mediante scraping.

- Herramientas de procesamiento de datos y técnicas de aprendizaje automático pueden ayudar a estructurar y analizar datos no estructurados extraídos mediante scraping.

- ¿Cómo afecta el GDPR al Web Scraping?

- El Reglamento General de Protección de Datos (GDPR) de la Unión Europea impone restricciones en la recolección y uso de datos personales, lo que puede afectar las prácticas de Web Scraping si involucran datos personales de ciudadanos de la UE.

Estas preguntas y respuestas buscan proporcionar una guía básica y aclarar las dudas más comunes sobre el Web Scraping, un campo en constante evolución y de gran relevancia en la era de la información digital.

Conclusión

El Web Scraping se ha convertido en una herramienta indispensable en la era digital, ofreciendo innumerables posibilidades para el análisis de datos, la automatización y la inteligencia de negocios. Al concluir esta guía, es esencial destacar varios puntos clave:

Potencial y Aplicaciones: El Web Scraping permite a las empresas y a los individuos acceder a un vasto océano de datos en la web, que pueden ser utilizados para informar decisiones, entender tendencias del mercado, y realizar investigaciones competitivas.

Legalidad y Ética: Siempre es crucial considerar la legalidad y la ética al realizar Web Scraping. Respetar los términos de servicio de los sitios web y las leyes locales sobre privacidad y propiedad de datos es fundamental para evitar problemas legales.

Desafíos Técnicos: Aunque el scraping puede ser técnicamente desafiante, especialmente en sitios web dinámicos o con medidas anti-scraping, la evolución constante de las herramientas y técnicas disponibles lo hace cada vez más accesible.

Importancia de la Calidad de Datos: No solo es importante extraer datos, sino asegurarse de que estos sean precisos, relevantes y útiles. La calidad de los datos scrapeados es crucial para cualquier análisis posterior o aplicación práctica.

Adaptabilidad y Aprendizaje Continuo: El campo del Web Scraping está en constante evolución, por lo que mantenerse actualizado con las últimas herramientas, técnicas y mejores prácticas es vital para maximizar su eficacia y eficiencia.

Balance entre Acceso y Privacidad: Es fundamental encontrar un equilibrio entre el acceso a la información y el respeto a la privacidad y seguridad de los datos. Las empresas y los individuos deben ser conscientes de este balance al realizar actividades de scraping.

En resumen, el Web Scraping es una práctica poderosa que, cuando se utiliza de manera responsable y ética, puede aportar un valor significativo en diversas áreas como el marketing, la investigación, el desarrollo de productos y mucho más. Con el conocimiento adecuado y una consideración cuidadosa de sus implicaciones, puede ser una herramienta inmensamente útil en el arsenal digital de cualquier profesional o entusiasta de la tecnología.