El posicionamiento web y la visibilidad online son esenciales, entender y manejar correctamente el archivo robots txt se convierte en una habilidad crucial para webmasters y profesionales del SEO. Este archivo pequeño pero poderoso actúa como la primera línea de comunicación entre tu sitio web y los motores de búsqueda. En esta guía, no solo exploraremos qué es y cómo funciona este archivo, sino que también te proporcionaremos las herramientas para utilizarlo efectivamente, mejorando así el rendimiento de tu sitio en los motores de búsqueda.

La correcta implementación del archivo robots txt puede significar la diferencia entre un sitio web completamente rastreado y uno que es ignorado parcialmente por los motores de búsqueda. Es más que un simple conjunto de instrucciones; es una declaración estratégica sobre cómo quieres que tu sitio sea indexado. Al dominar su uso, puedes mejorar significativamente la eficiencia del rastreo de tu sitio, asegurándote de que las páginas importantes sean priorizadas y las irrelevantes o privadas queden fuera del alcance de los buscadores.

Nuestra guía está diseñada para llevarte paso a paso a través de todo lo relacionado con el archivo robots txt. Desde su creación y edición hasta las mejores prácticas para su implementación, te equiparemos con el conocimiento necesario para optimizar tu sitio de manera efectiva. Ya seas un novato en SEO o un experto en el campo, esta guía te proporcionará valiosos insights y técnicas para aprovechar al máximo el archivo robots.txt en tu estrategia de SEO.

¿Qué es robots txt?

robots txt es más que un simple archivo de texto; es una herramienta esencial de control para cualquier propietario de un sitio web. Este archivo actúa como un guardián digital, determinando cómo los motores de búsqueda interactúan con las diferentes secciones de tu sitio. Su función principal es comunicar a los robots de búsqueda, como Googlebot, qué áreas de tu sitio deben ser indexadas y cuáles deben quedar excluidas. Esta capacidad de dirigir el tráfico de rastreo es vital para optimizar la carga de trabajo de los motores de búsqueda y la visibilidad de tu contenido en línea.

Ubicado en la raíz del dominio de tu sitio, el archivo robots txt es uno de los primeros puntos de contacto entre tu sitio y los motores de búsqueda. Al visitar un sitio, los rastreadores buscan este archivo para obtener instrucciones sobre cómo proceder. Por ejemplo, si tienes una sección en tu sitio que es solo para miembros o contiene información sensible, puedes usar robots txt para evitar que estas páginas sean indexadas y aparezcan en los resultados de búsqueda.

Además de ser una herramienta de privacidad y seguridad, el archivo robots txt es fundamental en la estrategia SEO. Al permitirte priorizar el contenido que quieres que sea rastreado, ayuda a asegurar que los motores de búsqueda encuentren y indexen tus páginas más importantes. Esto es especialmente crucial en sitios grandes, donde la economía de recursos de rastreo puede afectar directamente tu visibilidad en línea.

En resumen, el archivo robots txt es un componente vital en la gestión de tu presencia online. Configurarlo correctamente no solo mejora la eficiencia del rastreo de motores de búsqueda, sino que también asegura que tu contenido más valioso sea descubierto y destacado en los resultados de búsqueda. Con un buen manejo de este archivo, puedes ejercer un control significativo sobre la imagen y el acceso a tu sitio web en el vasto mundo de Internet.

¿Cómo funciona un archivo robots txt?

El archivo robots txt funciona como un conjunto de instrucciones para los rastreadores de motores de búsqueda, dictando su comportamiento cuando visitan tu sitio. Estas instrucciones son interpretadas por los rastreadores antes de que examinen cualquier otra parte de tu sitio web, asegurando que sigan las reglas establecidas. Cada línea en el archivo robots txt da una instrucción específica a los rastreadores, ya sea para permitir o evitar el acceso a secciones particulares de tu sitio.

La estructura del archivo robots.txt es sencilla pero poderosa. Comienza especificando el User-agent, que es el rastreador al que se dirigen las instrucciones. Por ejemplo, User-agent: * se aplica a todos los rastreadores, mientras que User-agent: Googlebot se dirige específicamente al rastreador de Google. A continuación, se utilizan las directivas Allow y Disallow para controlar el acceso. Disallow: /privado/ le dice a los rastreadores que no accedan a la carpeta «privado», mientras que Allow: /publico/ indica que la carpeta «publico» está abierta al rastreo.

Es importante destacar que robots.txt no es un mecanismo de seguridad. Si bien puede evitar que los rastreadores respetuosos indexen ciertas páginas, no impide que los usuarios o rastreadores malintencionados accedan a esas áreas de tu sitio. Por lo tanto, información sensible o confidencial nunca debe depender únicamente de robots.txt para su protección.

Además, el comportamiento de los rastreadores frente al archivo robots txt puede variar. Mientras que los rastreadores principales como Googlebot suelen respetar las instrucciones de robots txt, algunos rastreadores más pequeños o menos éticos pueden ignorarlas. Esto significa que aunque el archivo robots.txt es una herramienta poderosa para la gestión del rastreo, no es infalible.

En resumen, el archivo robots.txt es una guía para los rastreadores sobre cómo interactuar con tu sitio. Al proporcionar instrucciones claras y específicas, puedes influir en qué contenido es indexado y cómo se utiliza el ancho de banda de rastreo, lo que puede tener un impacto significativo en la eficiencia y efectividad de tu SEO.

¿Dónde se encuentra el fichero robots.txt en WordPress?

Encontrar el archivo robots txt en WordPress es sorprendentemente sencillo, pero su ubicación y gestión pueden variar ligeramente dependiendo de cómo esté configurado tu sitio web. De forma predeterminada, WordPress genera automáticamente un archivo robots.txt virtual que no existe físicamente en tu servidor, pero está accesible para los rastreadores web.

Para localizar este archivo, simplemente añade /robots.txt al final de la URL de tu dominio principal. Por ejemplo, si tu sitio web es www.ejemplo.com, puedes encontrar tu archivo robots txt en www.ejemplo.com/robots.txt. Al acceder a esta URL, verás las directivas actuales que WordPress ha establecido para los rastreadores web.

Si necesitas personalizar el archivo robots.txt en WordPress, hay varias opciones. Una forma es crear un archivo físico robots txt. Esto se hace generando un archivo de texto llamado robots.txt y subiéndolo a la raíz de tu servidor web a través de un cliente FTP o el administrador de archivos de tu servicio de hosting. Esta opción te da control total sobre el contenido del archivo, permitiéndote establecer tus propias reglas de indexación.

Otra opción es utilizar plugins de SEO para WordPress. Muchos de estos plugins incluyen funcionalidades para editar el archivo robots txt directamente desde el panel de administración de WordPress. Esta opción es especialmente útil si no te sientes cómodo trabajando directamente con archivos de servidor o si prefieres una interfaz más amigable para gestionar tus directivas de SEO.

Es importante recordar que cualquier cambio que hagas en el archivo robots.txt debe hacerse con cuidado. Un error en este archivo puede tener consecuencias significativas, como impedir que los motores de búsqueda rastreen y indexen partes importantes de tu sitio.

En resumen, el archivo robots. xt en WordPress puede ser accesado fácilmente a través de la URL de tu sitio, y personalizado ya sea subiendo un archivo físico al servidor o utilizando plugins de SEO. Su ubicación accesible y la facilidad de edición hacen que sea una tarea sencilla para cualquier administrador de sitio web manejar este importante aspecto de la optimización de motores de búsqueda.

¿Qué reglas incluir en el archivo robots.txt?

El archivo robots txt juega un papel crucial en el SEO y la gestión del tráfico de los rastreadores web. Decidir qué reglas incluir en este archivo depende de tus objetivos específicos para el sitio y de cómo deseas que los motores de búsqueda interactúen con él. Aquí te presento algunas reglas comunes y sus propósitos:

- Bloquear áreas no públicas: Puedes utilizar

Disallow: /directorio-privado/para evitar que los rastreadores accedan a partes de tu sitio que no son para el público general, como paneles de administración o directorios específicos que no aportan valor SEO. - Prevenir el rastreo de archivos específicos: Si hay tipos de archivo que no deseas que sean indexados (como PDFs o archivos de imagen), puedes especificarlo con una regla como

Disallow: /*.pdf$. - Limitar el acceso a rastreadores específicos: Si prefieres que ciertos rastreadores no visiten tu sitio, puedes especificarlos con

User-agent: NombreDelRastreadorseguido deDisallow: /. Es importante ser cauteloso con esta regla, ya que podría afectar tu visibilidad en ciertos motores de búsqueda. - Permitir el acceso total: Si deseas que todos los rastreadores accedan a todo tu sitio, puedes usar

User-agent: *seguido deAllow: /. Esta es la configuración predeterminada en muchos casos, pero declararla puede ser útil para sobrescribir reglas previas. - Sitemap: Incluir la ubicación de tu sitemap con

Sitemap: http://www.ejemplo.com/sitemap.xmlayuda a los rastreadores a encontrar y entender la estructura de tu sitio más eficientemente.

Es esencial recordar que robots.txt no es una herramienta de seguridad. La información sensible no debe confiar únicamente en este archivo para su protección. Además, las reglas en robots txt son solo directrices y rastreadores no respetuosos pueden ignorarlas.

En resumen, las reglas en tu archivo robots txt deben ser cuidadosamente consideradas y adaptadas a las necesidades específicas de tu sitio. Seleccionar las directivas adecuadas puede mejorar significativamente la eficiencia del rastreo y la presencia en línea de tu sitio web.

¿Cómo crear un archivo robots.txt de forma manual y con WordPress?

Crear un archivo robots txt es un paso importante tanto para la gestión del SEO como para el control del acceso de los rastreadores web a tu sitio. Aquí te explicaré cómo hacerlo de forma manual y también utilizando WordPress.

Creación Manual

- Usa un Editor de Texto: Abre un editor de texto básico como Notepad en Windows o TextEdit en macOS.

- Escribe las Reglas: Escribe las directivas que desees implementar, como

User-agent: *yDisallow: /directorio-secreto/. - Guarda el Archivo: Guarda el archivo con el nombre

robots txt. Asegúrate de que no tenga ninguna extensión adicional como .txt o .docx. - Sube a tu Servidor: Utiliza un cliente FTP o el administrador de archivos de tu hosting para subir el archivo a la raíz de tu dominio. Esto significa que debe estar al mismo nivel que tu carpeta principal de WordPress (generalmente public_html).

Creación con WordPress

- Plugins de SEO: Instala un plugin de SEO como Yoast SEO o All in One SEO. Estos plugins tienen opciones integradas para editar el archivo robots txt.

- Accede a la Configuración del Plugin: Ve a la sección de herramientas o configuración avanzada del plugin.

- Edita robots.txt: Busca la opción para editar el archivo robots txt. Aquí, puedes ingresar tus directivas directamente en una interfaz amigable.

- Guarda los Cambios: Una vez que hayas terminado, guarda los cambios. El plugin actualizará automáticamente el archivo robots.txt virtual de WordPress.

Consideraciones Adicionales

- Prueba tus Cambios: Después de crear o modificar tu archivo robots txt, es vital probarlo para asegurarte de que funciona como esperas. Puedes usar herramientas como Google Search Console para esto.

- Manténlo Simple: Evita reglas demasiado complicadas, ya que podrían confundir a los rastreadores o bloquear contenido importante sin querer.

- Revisa Regularmente: Las necesidades de tu sitio pueden cambiar, así que revisa y actualiza tu archivo robots txt regularmente.

Crear un archivo robots.txt, ya sea manualmente o mediante WordPress, es un proceso sencillo, pero requiere atención y cuidado para asegurarse de que las directivas aplicadas sean las adecuadas para tus objetivos de SEO y privacidad del sitio.

Ejemplos de comandos más utilizados en robots.txt

El archivo robots.txt es esencial para dirigir el comportamiento de los rastreadores web en tu sitio. Aquí te presento algunos ejemplos de comandos comúnmente utilizados, explicando su propósito y cómo puedes implementarlos:

- Bloquear a Todos los Rastreadores de una Parte del Sitio:

- Comando:

User-agent: *seguido deDisallow: /carpeta-privada/ - Propósito: Este comando es útil para evitar que cualquier rastreador acceda a una sección específica de tu sitio, como un directorio privado o páginas en desarrollo.

- Implementación: Coloca estos comandos en líneas separadas para asegurar su correcta interpretación.

- Comando:

- Permitir el Acceso Total a Todos los Rastreadores:

- Comando:

User-agent: *seguido deAllow: / - Propósito: Este comando es utilizado para permitir que todos los rastreadores accedan a todas las áreas de tu sitio. Es especialmente útil si previamente has establecido reglas restrictivas y deseas revocarlas.

- Implementación: Úsalo con precaución para no sobrescribir reglas de exclusión importantes.

- Comando:

- Excluir Archivos Específicos:

- Comando:

Disallow: /*.pdf$ - Propósito: Este comando impide que los rastreadores indexen archivos específicos, en este caso, todos los archivos PDF. Es útil para contenido que no deseas que aparezca en los resultados de búsqueda.

- Implementación: Puedes modificar la extensión para ajustarse al tipo de archivo que deseas excluir.

- Comando:

- Limitar el Acceso a un Rastreador Específico:

- Comando:

User-agent: Googlebotseguido deDisallow: /no-google/ - Propósito: Este comando bloquea a un rastreador específico (en este caso, Googlebot) de acceder a una parte específica del sitio. Es útil si quieres controlar cómo diferentes motores de búsqueda indexan tu sitio.

- Implementación: Reemplaza «Googlebot» con el nombre del rastreador que deseas restringir.

- Comando:

- Indicar la Ubicación del Sitemap:

- Comando:

Sitemap: http://www.ejemplo.com/sitemap.xml - Propósito: Este comando ayuda a los rastreadores a encontrar tu sitemap, facilitando una indexación más eficiente de tu sitio.

- Implementación: Asegúrate de que la URL proporcionada sea la ubicación exacta de tu sitemap.

- Comando:

Cada uno de estos comandos debe ser cuidadosamente considerado en función de tus necesidades específicas de SEO y gestión del sitio. Recuerda que las reglas en robots.txt son directrices, no garantías, y los rastreadores respetuosos las seguirán según lo establecido.

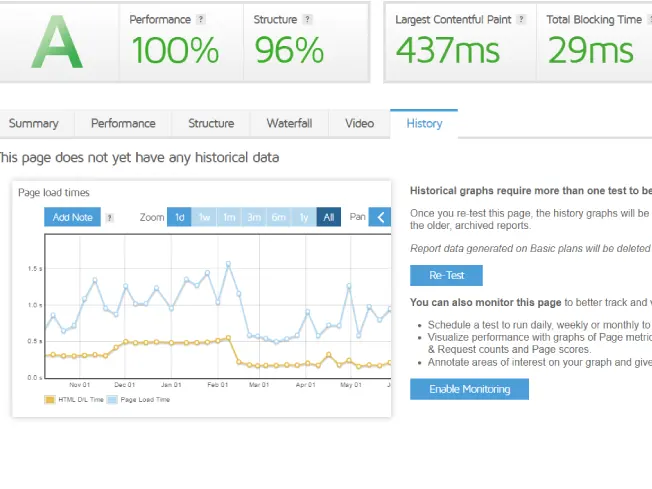

Cómo probar el fichero robots.txt

Probar el archivo robots txt es crucial para asegurarte de que está configurado correctamente y no está bloqueando el acceso a contenido importante o permitiendo el acceso a contenido sensible. A continuación, te explico cómo puedes realizar estas pruebas de manera efectiva:

Uso de Google Search Console

- Acceso a la Herramienta: Inicia sesión en Google Search Console. Esta herramienta de Google es fundamental para comprender cómo los rastreadores ven tu sitio.

- Buscar la Función de Prueba: Dentro de Search Console, busca la sección de «robots txt Tester» o «Probador de robots.txt».

- Realizar la Prueba: Pega el contenido de tu archivo robots txt en el probador o selecciona tu sitio si ya está subido. Puedes escribir URLs específicas para ver si están bloqueadas o permitidas por tus reglas actuales.

- Interpretar los Resultados: La herramienta te mostrará si hay errores o problemas con las reglas que has establecido. Asegúrate de no tener reglas contradictorias o errores de sintaxis.

Herramientas de Terceros

- Explora Opciones: Existen varias herramientas en línea además de Google Search Console, como «Robots.txt Checker» o «SEO Book Robots.txt Analyzer».

- Evalúa la Usabilidad: Estas herramientas a menudo ofrecen interfaces fáciles de usar y explicaciones detalladas sobre cómo tus reglas afectan el acceso del rastreador.

- Realiza Pruebas Adicionales: Utiliza estas herramientas para probar diferentes escenarios y asegurarte de que tu archivo robots.txt funciona como esperas en diferentes contextos.

Pruebas Manuales

- Revisión Directa: Si tienes conocimiento técnico, puedes revisar manualmente el archivo para detectar errores comunes como rutas incorrectas o problemas de sintaxis.

- Consulta con Profesionales: Si no estás seguro de tu revisión, considera consultar con un experto en SEO o un desarrollador web.

Consideraciones Importantes

- Cambios Constantes: El mundo de la web está siempre cambiando. Lo que funciona hoy podría no funcionar mañana, así que mantén tus pruebas actualizadas.

- Cumplimiento de los Rastreadores: Recuerda que no todos los rastreadores respetan el archivo robots.txt. Las reglas que estableces son más como sugerencias para rastreadores éticos como Googlebot.

- Pruebas Después de Cambios: Siempre realiza pruebas después de realizar cambios en tu archivo robots.txt para evitar bloqueos o accesos no deseados.

Probar tu archivo robots.txt es un paso esencial para garantizar que tu sitio web sea rastreado e indexado correctamente. Utilizando estas metodologías, puedes identificar y corregir problemas potenciales, asegurando que tu sitio web se mantenga visible y accesible para los motores de búsqueda.

Conclusión

La gestión y optimización del archivo robots.txt es una faceta esencial en la administración de un sitio web, especialmente en términos de SEO y seguridad. A lo largo de esta guía, hemos explorado diversos aspectos cruciales que contribuyen a una comprensión integral de este archivo vital:

Importancia Fundamental: El archivo robots.txt juega un papel clave en cómo los motores de búsqueda interactúan con tu sitio. Es esencial para controlar y guiar el rastreo de tu contenido en la web.

Personalización Efectiva: Hemos aprendido que la personalización del archivo robots.txt debe hacerse con cuidado. Un mal manejo puede llevar a la no indexación de partes importantes de tu sitio o, por el contrario, exponer secciones que deberían permanecer privadas.

Herramienta de SEO: Este archivo no es solo una herramienta técnica, sino un componente crucial de tu estrategia de SEO. Permite maximizar la visibilidad de las secciones importantes de tu sitio y minimizar el desperdicio de recursos de rastreo en áreas irrelevantes.

Flexibilidad y Control: Te hemos mostrado cómo crear y modificar este archivo, ya sea de forma manual o utilizando herramientas proporcionadas por sistemas de gestión de contenidos como WordPress.

Ejemplos Prácticos: Los ejemplos de comandos que hemos discutido ofrecen un punto de partida para configurar tu archivo, adaptándolo a las necesidades específicas de tu sitio.

Pruebas y Mantenimiento: La importancia de probar y mantener actualizado tu archivo robots.txt no puede subestimarse. Es una práctica continua que asegura la efectividad de tus reglas de rastreo.

En resumen, el archivo robots.txt es mucho más que un mero conjunto de reglas para los rastreadores de motores de búsqueda. Es una herramienta estratégica que, si se utiliza sabiamente, puede mejorar significativamente la presencia en línea de tu sitio. Como con cualquier herramienta poderosa, viene con la responsabilidad de usarla con conocimiento y precaución. Mantenerse informado, realizar pruebas periódicas y adaptarse a los cambios en el entorno digital son prácticas esenciales para aprovechar al máximo las capacidades del archivo robots.txt.