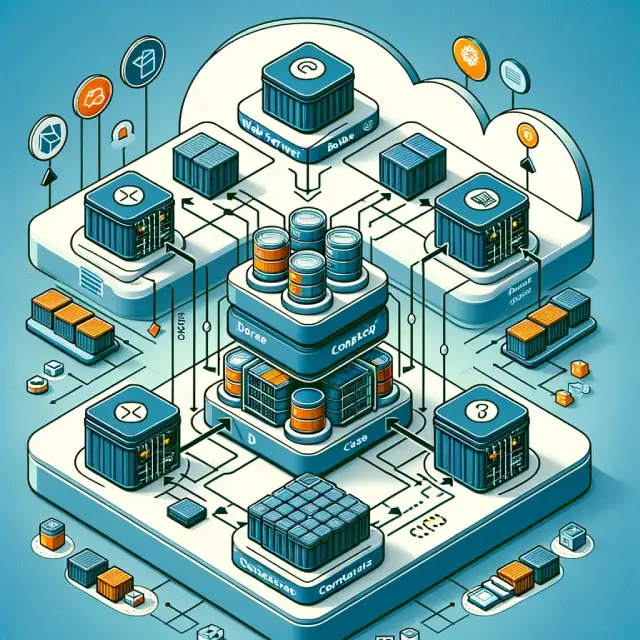

La necesidad de asegurar la coherencia entre los entornos de desarrollo, prueba y producción se ha vuelto más crítica que nunca. Docker emerge como una solución elegante a este desafío, ofreciendo a los desarrolladores una forma de empaquetar y distribuir sus aplicaciones en contenedores que son ligeros, portables y consistentes a través de diferentes entornos. Esto significa que los desarrolladores pueden enfocarse en escribir código sin preocuparse por las peculiaridades del entorno en el que se ejecutará su aplicación.

Con Docker, las aplicaciones se ejecutan en contenedores virtuales que comparten el mismo kernel del sistema operativo anfitrión pero funcionan como unidades discretas, asegurando que la aplicación se ejecute de la misma manera, sin importar dónde. La plataforma Docker no solo facilita el desarrollo y despliegue de aplicaciones sino que también mejora significativamente la eficiencia y la seguridad.

La introducción de Docker-Compose ha llevado esta conveniencia un paso adelante, permitiendo a los desarrolladores orquestar y manejar aplicaciones compuestas por múltiples contenedores con una facilidad sorprendente. Esto es particularmente beneficioso en entornos complejos, donde las aplicaciones consisten en varios servicios interconectados que deben ser gestionados simultáneamente. Docker-Compose utiliza un archivo YAML para definir cómo estos servicios interconectados deben ser construidos, conectados y ejecutados, haciendo el proceso de gestión de aplicaciones multicontenedor tan simple como ejecutar un comando.

Qué es Docker

Docker es una plataforma revolucionaria de contenerización que ha transformado la forma en que los desarrolladores construyen, envían y ejecutan aplicaciones. Utilizando contenedores, Docker permite a los usuarios empaquetar una aplicación con todas sus dependencias en una unidad estándar para el desarrollo de software. Esta tecnología garantiza que la aplicación se ejecute de manera idéntica en cualquier entorno, desde el desarrollo hasta la producción, eliminando el típico problema de «funciona en mi máquina, pero no en la tuya».

La magia detrás de Docker radica en su capacidad para crear contenedores ligeros que se ejecutan de manera aislada, pero dentro del mismo núcleo del sistema operativo. Esto significa que los contenedores son mucho más eficientes en términos de recursos que las máquinas virtuales tradicionales, que necesitan un sistema operativo completo. Además, Docker facilita la gestión de la infraestructura de la misma manera que se gestionan las aplicaciones, permitiendo a los desarrolladores automatizar el despliegue de aplicaciones en cualquier entorno.

Una de las principales fortalezas de Docker es su ecosistema robusto y su extensa biblioteca de imágenes Docker, que están disponibles en Docker Hub. Estas imágenes pueden ser usadas como base para construir contenedores, lo que ahorra tiempo y esfuerzo en la configuración y el despliegue de entornos y aplicaciones. Desde bases de datos y sistemas de mensajería hasta entornos de desarrollo y lenguajes de programación, las imágenes de Docker cubren casi todas las necesidades que un desarrollador pueda tener.

Qué es Docker-compose

Docker-compose es una herramienta esencial que facilita el desarrollo, la prueba y la implementación de aplicaciones compuestas por múltiples contenedores Docker. Actúa como un orquestador de contenedores, permitiendo a los desarrolladores definir y ejecutar aplicaciones multicontenedor utilizando archivos YAML. Este enfoque declarativo simplifica enormemente el proceso de configuración de los servicios que componen una aplicación, permitiendo que se especifiquen todas las dependencias y configuraciones en un documento fácil de entender.

Una de las grandes ventajas de Docker-Compose es su capacidad para automatizar y replicar entornos de aplicación con precisión. Los desarrolladores pueden definir no solo las imágenes de contenedor que se utilizan, sino también configurar redes, volúmenes y otros servicios necesarios, asegurando que la aplicación se ejecute de manera uniforme en cualquier entorno. Esto es particularmente útil en las fases tempranas de desarrollo y en CI/CD (Integración Continua/Despliegue Continuo), donde la consistencia y la automatización son clave para un flujo de trabajo eficiente.

Otra característica destacada de Docker-Compose es su simplicidad para escalar aplicaciones. Con solo unos pocos comandos, los desarrolladores pueden aumentar o disminuir el número de instancias de un servicio en particular, adaptándose a las necesidades de carga sin complicaciones. Esta flexibilidad es crucial para aplicaciones que experimentan variaciones en la demanda y necesitan una forma eficiente de escalar.

Docker-Compose también fomenta una mejor colaboración dentro de los equipos de desarrollo. Al compartir el archivo docker-compose.yml, los miembros del equipo pueden lanzar y ejecutar una réplica exacta del entorno de desarrollo de la aplicación, eliminando los problemas de «funcionaba en mi máquina». Esto no solo mejora la eficiencia del equipo sino que también reduce los ciclos de prueba y error al mover aplicaciones entre diferentes etapas de desarrollo y producción.

Cómo instalar Docker en Ubuntu

Instalar Docker en Ubuntu es un proceso que se puede completar en unos pocos pasos. Este proceso comienza con la actualización del sistema para asegurarse de que todas las dependencias estén al día. Utilizando el comando sudo apt-get update, los usuarios pueden sincronizar el índice de paquetes de su sistema con los repositorios de Ubuntu, asegurando que las últimas versiones de los paquetes estén disponibles para la instalación.

El siguiente paso involucra instalar algunos paquetes pre-requisitos necesarios para que apt pueda acceder a los paquetes a través de HTTPS. Los paquetes como apt-transport-https, ca-certificates, curl, y software-properties-common se pueden instalar fácilmente con el comando sudo apt-get install apt-transport-https ca-certificates curl software-properties-common. Estos paquetes permiten una comunicación segura con los servidores de Docker y son esenciales para el siguiente paso del proceso de instalación.

Para agregar de forma segura la clave GPG oficial de Docker a su sistema, se utiliza el comando curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo apt-key add -. Esto asegura que los paquetes descargados sean autenticados y seguros para la instalación. Después de agregar la clave GPG, el siguiente paso es añadir el repositorio oficial de Docker a las fuentes de APT. Esto se hace con el comando sudo add-apt-repository "deb [arch=amd64] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable", lo que garantiza que se instale la versión más reciente y estable de Docker.

Una vez que el repositorio de Docker ha sido agregado y el índice de paquetes actualizado nuevamente con sudo apt-get update, el usuario puede proceder a instalar Docker utilizando el comando sudo apt-get install docker-ce. Este comando instala la edición comunitaria de Docker, Docker Community Edition (CE), que es gratuita y ampliamente utilizada por desarrolladores y equipos pequeños.

Después de la instalación, es una buena práctica verificar que Docker se haya instalado correctamente y esté funcionando. Esto se puede hacer ejecutando el comando sudo docker run hello-world, que debería descargar una imagen de prueba y ejecutar un contenedor que imprime un mensaje en la consola, confirmando que Docker está correctamente instalado y funcionando en Ubuntu.

Además de instalar Docker, es importante considerar la gestión de usuarios y permisos. Por defecto, para ejecutar comandos de Docker se requiere privilegios de superusuario (sudo). Para evitar tener que usar sudo para cada comando de Docker, se puede agregar el usuario a un grupo llamado docker con el comando sudo usermod -aG docker ${USER}. Después de reiniciar la sesión (o el sistema), el usuario podrá ejecutar comandos de Docker sin necesidad de privilegios elevados.

Cómo agregar repositorios de Docker

Agregar repositorios de Docker a tu sistema es un paso crucial para asegurarte de que estás instalando la versión más reciente y segura de Docker. Este proceso permite a tu sistema obtener acceso directo a los paquetes oficiales de Docker, en lugar de depender de las versiones que puedan estar disponibles en los repositorios predeterminados de Ubuntu, que podrían estar desactualizadas o no ser completamente compatibles con tu configuración.

El primer paso para agregar el repositorio oficial de Docker consiste en asegurarse de que tu sistema pueda manejar repositorios sobre HTTPS. Esto se logra instalando varios paquetes pre-requisitos como apt-transport-https, ca-certificates, curl, y software-properties-common. Estos paquetes son esenciales porque habilitan la comunicación segura entre tu máquina y los servidores de Docker, lo cual es fundamental para la seguridad y la integridad de las aplicaciones que desplegarás.

Una vez que estos paquetes están instalados, el siguiente paso es importar la clave GPG oficial de Docker. Esto se hace para verificar la autenticidad de los paquetes descargados, asegurando que son genuinos y no han sido alterados de ninguna manera. El comando curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo apt-key add - permite descargar y añadir la clave al sistema de gestión de paquetes de tu máquina.

Con la clave GPG añadida, el siguiente paso es añadir el repositorio oficial de Docker a las fuentes de APT de tu sistema. Esto se realiza mediante el comando sudo add-apt-repository "deb [arch=amd64] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable". Este comando especifica el repositorio de Docker para la arquitectura amd64, asegurando que se utilice la versión correcta del repositorio para tu versión específica de Ubuntu. Es importante señalar que $(lsb_release -cs) se utiliza para identificar automáticamente el nombre de código de tu versión de Ubuntu, garantizando que el repositorio añadido sea compatible con tu sistema.

Después de añadir el repositorio, un último sudo apt-get update es necesario para actualizar el índice de paquetes de tu sistema con los nuevos paquetes disponibles desde el repositorio de Docker que acabas de añadir. Este paso finaliza la configuración del repositorio, y tu sistema está ahora listo para instalar la última versión de Docker CE (Community Edition) o Docker EE (Enterprise Edition), dependiendo de tus necesidades específicas.

Este proceso no solo asegura que tengas acceso a las últimas características y actualizaciones de seguridad de Docker sino que también te prepara para mantener tu entorno de desarrollo tan eficiente y seguro como sea posible. La adición de repositorios oficiales es un paso fundamental para cualquier administrador de sistemas o desarrollador que busque aprovechar al máximo las capacidades de Docker en su flujo de trabajo.

Comandos Docker

Uno de los comandos más utilizados es docker run, que permite a los usuarios crear y ejecutar un contenedor a partir de una imagen. Este comando es increíblemente versátil, ofreciendo opciones para configurar redes, volúmenes y variables de entorno, entre otros. Por ejemplo, docker run -d -p 80:80 --name webserver nginx inicia un contenedor nginx en modo desacoplado, mapea el puerto 80 del contenedor al puerto 80 del host y lo nombra «webserver».

Para construir imágenes personalizadas basadas en un Dockerfile, se utiliza el comando docker build. Este comando toma el contexto de un directorio especificado, que incluye el Dockerfile y cualquier archivo necesario para construir la imagen, y crea una imagen que puede ser ejecutada posteriormente por Docker. Por ejemplo, docker build -t mi-aplicacion:1.0 . construiría una imagen llamada «mi-aplicacion» con la etiqueta «1.0» a partir del Dockerfile en el directorio actual.

La gestión de imágenes es otra área donde los comandos Docker brillan. El comando docker images lista todas las imágenes disponibles en el host, proporcionando información como el repositorio, la etiqueta y el tamaño de cada imagen. Esto es útil para tener una visión general de las imágenes disponibles para su uso o despliegue.

El comando docker ps es esencial para listar los contenedores en ejecución, mostrando detalles útiles como el ID del contenedor, la imagen de base, los comandos en ejecución y el mapeo de puertos. Para ver tanto los contenedores en ejecución como los detenidos, se puede utilizar docker ps -a.

Docker-compose es otra herramienta crucial en el ecosistema Docker, especialmente para la gestión de aplicaciones multicontenedor. Los comandos como docker-compose up y docker-compose down permiten a los usuarios iniciar y detener todos los servicios definidos en un archivo docker-compose.yml con un solo comando, simplificando significativamente la gestión de aplicaciones complejas.

Gestión de Contenedores

docker run: Crea y ejecuta un contenedor a partir de una imagen.- Ejemplo:

docker run -d -p 80:80 --name mi_contenedor nginx

- Ejemplo:

docker stop: Detiene uno o más contenedores en ejecución.- Ejemplo:

docker stop mi_contenedor

- Ejemplo:

docker start: Inicia uno o más contenedores detenidos.- Ejemplo:

docker start mi_contenedor

- Ejemplo:

docker restart: Reinicia un contenedor.- Ejemplo:

docker restart mi_contenedor

- Ejemplo:

docker rm: Elimina uno o más contenedores.- Ejemplo:

docker rm mi_contenedor

- Ejemplo:

docker ps: Lista los contenedores en ejecución.- Ejemplo:

docker ps

- Ejemplo:

docker ps -a: Lista todos los contenedores, incluyendo los detenidos.- Ejemplo:

docker ps -a

- Ejemplo:

Gestión de Imágenes

docker images: Lista las imágenes disponibles.- Ejemplo:

docker images

- Ejemplo:

docker build: Construye una imagen a partir de un Dockerfile.- Ejemplo:

docker build -t mi_aplicacion:1.0 .

- Ejemplo:

docker pull: Descarga una imagen o un repositorio desde un registro.- Ejemplo:

docker pull nginx

- Ejemplo:

docker push: Sube una imagen o un repositorio a un registro.- Ejemplo:

docker push mi_usuario/mi_aplicacion:1.0

- Ejemplo:

docker rmi: Elimina una o más imágenes.- Ejemplo:

docker rmi mi_aplicacion:1.0

- Ejemplo:

Gestión de Redes

docker network create: Crea una nueva red.- Ejemplo:

docker network create mi_red

- Ejemplo:

docker network ls: Lista todas las redes.- Ejemplo:

docker network ls

- Ejemplo:

docker network rm: Elimina una o más redes.- Ejemplo:

docker network rm mi_red

- Ejemplo:

Gestión de Volúmenes

docker volume create: Crea un volumen.- Ejemplo:

docker volume create mi_volumen

- Ejemplo:

docker volume ls: Lista todos los volúmenes.- Ejemplo:

docker volume ls

- Ejemplo:

docker volume rm: Elimina uno o más volúmenes.- Ejemplo:

docker volume rm mi_volumen

- Ejemplo:

Docker Compose

docker-compose up: Construye, (re)crea, inicia y conecta contenedores para un servicio.- Ejemplo:

docker-compose up

- Ejemplo:

docker-compose down: Detiene y elimina los contenedores, redes, imágenes y volúmenes.- Ejemplo:

docker-compose down

- Ejemplo:

Utilidades y Mantenimiento

docker logs: Muestra los logs de un contenedor.- Ejemplo:

docker logs mi_contenedor

- Ejemplo:

docker exec: Ejecuta un comando en un contenedor en ejecución.- Ejemplo:

docker exec -it mi_contenedor bash

- Ejemplo:

docker system prune: Elimina contenedores, redes e imágenes no utilizados.- Ejemplo:

docker system prune

- Ejemplo:

Uso de contenedores Docker

el uso de contenedores Docker ha revolucionado la forma en que las aplicaciones se desarrollan, se prueban y se despliegan, ofreciendo una solución eficiente y escalable para manejar la infraestructura de aplicaciones. Los contenedores Docker proporcionan un entorno aislado y consistente para cada aplicación, asegurando que funcione de manera uniforme a través de diferentes entornos de desarrollo, prueba y producción. Esta consistencia elimina el clásico problema de «funciona en mi máquina», facilitando la colaboración entre desarrolladores y agilizando el ciclo de vida del desarrollo de software.

Una de las principales ventajas de los contenedores Docker es su ligereza y rapidez. A diferencia de las máquinas virtuales tradicionales, que requieren su propio sistema operativo, los contenedores Docker comparten el kernel del sistema operativo del host, pero se ejecutan como procesos aislados. Esto no solo reduce significativamente el uso de recursos, sino que también permite que los contenedores se inicien casi instantáneamente, proporcionando una manera más eficiente de escalar aplicaciones según sea necesario.

El aislamiento que ofrecen los contenedores Docker es otro beneficio clave. Cada contenedor opera de manera independiente, con su propia instancia de sistema de archivos, recursos de red y procesos. Esto asegura que los cambios en un contenedor no afecten a otros, lo que hace que la gestión de dependencias y la configuración de entornos sea mucho más sencilla. Además, este nivel de aislamiento fortalece la seguridad, ya que los contenedores proporcionan una capa adicional de separación entre aplicaciones.

Docker también simplifica el manejo de dependencias. Al empaquetar una aplicación y todas sus dependencias en un contenedor, los desarrolladores pueden estar seguros de que la aplicación se ejecutará sin problemas en cualquier otro sistema que soporte Docker. Esta portabilidad es especialmente valiosa en arquitecturas de microservicios, donde diferentes servicios, posiblemente escritos en diferentes lenguajes de programación y con distintas dependencias, deben interactuar de manera fluida.

El despliegue y la escalabilidad son considerablemente mejorados con Docker. Los contenedores se pueden desplegar en una amplia variedad de entornos, desde servidores físicos hasta plataformas de nube y sistemas de orquestación como Kubernetes. Docker Compose, en particular, facilita la gestión de aplicaciones multicontenedor, permitiendo a los desarrolladores definir y desplegar servicios interconectados con un solo archivo de configuración y comandos simples.

En el contexto de la integración y entrega continuas (CI/CD), Docker juega un papel crucial. Los contenedores pueden ser utilizados para crear pipelines de CI/CD eficientes, donde las aplicaciones se construyen, prueban y despliegan automáticamente en varios entornos, acelerando el lanzamiento de nuevas características y mejoras, mientras se minimizan los riesgos de errores.

Preguntas frecuentes

¿Docker es solo para aplicaciones Linux? Aunque Docker comenzó enfocándose en la contenerización de aplicaciones Linux, su ecosistema se ha expandido significativamente. Docker Desktop para Windows y Mac permite desarrollar y ejecutar contenedores nativamente en estos sistemas operativos, utilizando máquinas virtuales bajo el capó para proporcionar compatibilidad. Esto significa que los desarrolladores pueden utilizar Docker en una variedad de entornos de desarrollo, independientemente del sistema operativo.

¿Cómo se diferencia Docker de una máquina virtual? La principal diferencia radica en su arquitectura. Las máquinas virtuales incluyen un sistema operativo completo para cada instancia, lo que consume más recursos y tarda más en iniciarse. Docker, por otro lado, utiliza contenedores que comparten el kernel del sistema operativo del host pero se ejecutan en procesos aislados, lo que resulta en un arranque más rápido y un menor uso de recursos. Esta eficiencia hace de Docker una solución ideal para despliegue y escalado de aplicaciones.

¿Es Docker seguro? La seguridad es una preocupación común cuando se trata de tecnologías de contenerización. Docker proporciona varias características de seguridad para ayudar a asegurar los contenedores, como el aislamiento de aplicaciones, políticas de red estrictas y la capacidad de gestionar sensibilidades y permisos a nivel de contenedor. Sin embargo, la seguridad de un contenedor Docker también depende de las prácticas de seguridad implementadas durante el proceso de desarrollo y despliegue de la aplicación.

¿Puedo usar Docker en entornos de producción? Absolutamente. Docker está diseñado para ser utilizado en entornos de desarrollo, prueba y producción. Su capacidad para empaquetar y ejecutar aplicaciones de manera consistente en cualquier entorno hace de Docker una herramienta valiosa para el ciclo de vida completo del desarrollo de software. Empresas de todos los tamaños utilizan Docker en producción para gestionar y escalar sus aplicaciones de manera eficiente.

¿Cómo maneja Docker los datos persistentes? Aunque los contenedores son efímeros por naturaleza, Docker permite el uso de volúmenes para almacenar datos persistentes. Los volúmenes son completamente gestionados por Docker y pueden ser montados en contenedores, proporcionando una manera de conservar datos incluso después de que un contenedor se elimine o actualice. Esto es crucial para aplicaciones que requieren almacenamiento persistente, como bases de datos.

¿Docker reemplaza a Git? Docker y Git sirven para propósitos diferentes y complementarios. Git es un sistema de control de versiones utilizado para rastrear cambios en el código fuente durante el desarrollo de software, mientras que Docker se utiliza para empaquetar ese código en contenedores para su despliegue. En un flujo de trabajo típico, los desarrolladores utilizan Git para gestionar el código fuente y Docker para asegurar que este código se ejecute consistentemente en cualquier entorno.