Qué es resiliencia (y en qué se diferencia de fiabilidad y HA)

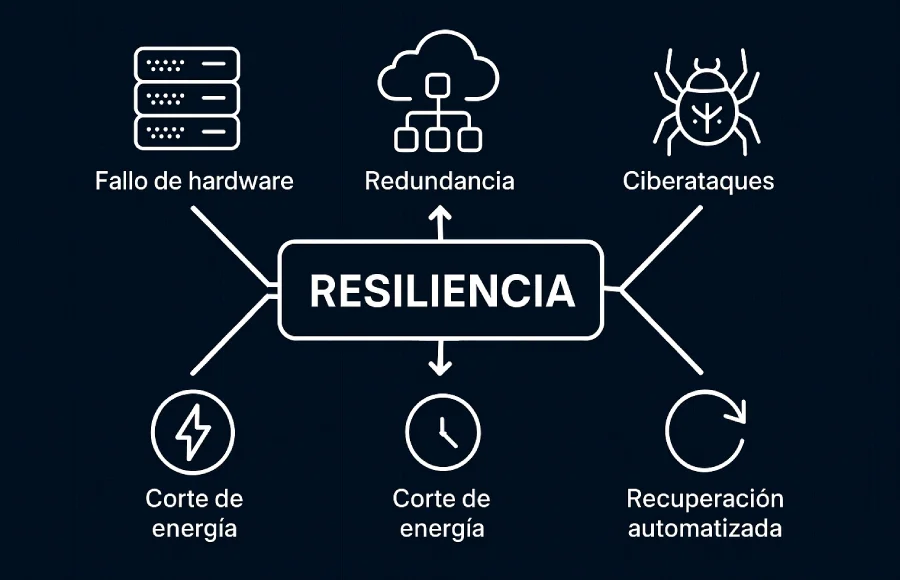

Cuando pienso en resiliencia, dejo de mirar los “caballos de fuerza” y empiezo a medir “confianza”. En la nube los fallos no son excepciones, son escenarios normales: un disco que muere, un nodo que no responde, una AZ que cae o un pico de tráfico anómalo. La pregunta útil nunca es “¿cómo evito que falle?”, sino “¿qué tan rápido sigo dando servicio cuando falle?”. Ahí se separa un sistema frágil de uno maduro.

Para ordenar ideas, conviene diferenciar términos que mucha gente usa como sinónimos:

| Concepto | Pregunta que responde | Cómo se mide | Ejemplo práctico |

|---|---|---|---|

| Fiabilidad | ¿Con qué frecuencia falla? | MTBF/MTTR, tasa de errores | Un servicio que rara vez se cae |

| Alta disponibilidad (HA) | ¿Está casi siempre arriba? | % de uptime (SLO) | Diseño multi-AZ con failover |

| Resiliencia | ¿Qué tan bien sigo operando cuando algo ya falló? | RTO, RPO, tiempo de degradación/recuperación | Degradación elegante + recuperación automatizada |

Traducción a números que importan:

- SLO/SLI: tu promesa y cómo la mides (latencia p95, tasa de éxito, uptime mensual).

- RTO (Recovery Time Objective): cuánto tiempo puedes tardar en recuperar el servicio.

- RPO (Recovery Point Objective): cuántos datos puedes permitirte perder (p. ej., 1 min vs 1 hora).

En mi caso, cuando defino resiliencia con un equipo, empiezo por estos objetivos y valido que el negocio los entienda: no es lo mismo tolerar 15 minutos de caída en un blog que en un checkout de e-commerce en pleno Black Friday.

Objetivos medibles: RTO, RPO, SLO y SLI

- Aterriza el SLO (p. ej., 99,95% mensual y latencia p95 < 300 ms).

- Fija RTO/RPO por dominio: base de datos, colas, almacenamiento de objetos, autenticación, pagos.

- Define “modos degradados” aceptables: ¿read-only? ¿deshabilitar búsquedas pesadas? ¿limitar adjuntos?

Pequeño truco que me ha funcionado: construye tu dashboard de SLI desde el diseño, no al final. Si no puedes medirlo el primer día, difícilmente lo cumplirás el día que algo se rompa.

Principios de diseño: redundancia inteligente, tolerancia a fallos y recuperación automatizada

He probado varias veces que copiar y pegar “doblando todo” es caro e ineficiente. Prefiero lo que llamo redundancia inteligente: duplico lo que rompe la experiencia si muere (DB, balanceadores, storage crítico) y no lo que sólo añade complejidad sin mover la aguja.

- Redundancia inteligente:

- DB y almacenamiento: réplicas en otra AZ o región; snapshots con retención; políticas de restauración probadas.

- Balanceadores/ingress: activos en multizona; políticas de salud agresivas con backoff.

- Stateful vs stateless: mantén stateless todo lo posible; lo stateful va con mimo (réplicas, quorum, fencing).

- Tolerancia a fallos (degradación elegante):

No es “todo o nada”. Un sistema maduro se degrada con elegancia: limita funcionalidades pesadas, pasa a modo read-only, encola peticiones diferibles o sirve contenido en caché. En un incidente real, he visto que este enfoque cambia un “apagón” por una molestia tolerable para el usuario. - Recuperación automatizada:

Cuanto menos dependes de que “alguien entre al servidor a arreglarlo”, más resiliente eres. Infraestructura como código, health checks realistas, auto-healing y runbooks que ejecuta un bot. Mi regla: si lo hicimos manual una vez en un incidente, la siguiente es automatizada.

Dónde sí duplicar (y dónde no): DB, balanceadores, almacenamiento

- Sí duplicar:

- Base de datos transaccional (réplicas + failover controlado);

- Almacenamiento de objetos crítico (versionado + replicación);

- Puntos únicos de entrada (LB, DNS, control planes con SLAs altos).

- Evaluar:

- Microservicios de baja criticidad que pueden reintentar o encolar.

- Herramientas internas que toleran downtime en horario no laboral.

- No duplicar a ciegas:

- Procesos batch sin impacto directo en el SLO;

- Servicios experimentales sin tráfico de cliente.

Degradación elegante: circuit breakers, colas y modos “read-only”

Patrones que me han dado paz mental:

- Circuit breaker + timeouts: mejor cortar y responder rápido con un fallback que colgar al usuario.

- Colas y reintentos con backoff: no mates tu DB con tormentas de reintentos.

- Modo read-only: útil para picos de lectura o mantenimiento; comunica el estado al front.

- Feature flags: recorta funciones pesadas durante la crisis sin redeploys.

Patrones que funcionan cuando todo falla

Activo-activo vs activo-pasivo: costes, riesgos y latencia

- Activo-activo: todo sirve en paralelo (multi-región o multi-AZ).

- Pro: RTO casi cero, escalado más suave.

- Contra: complejidad (consistencia de datos, enrutado global), coste duplicado.

- Úsalo cuando el RTO es ultra exigente y tus datos soportan replicación rápida.

- Activo-pasivo: primario sirve, secundario caliente/listo.

- Pro: más sencillo y barato.

- Contra: RTO > 0; exige simulacros.

- Úsalo cuando puedes tolerar minutos de recuperación y prefieres simplicidad.

Yo balanceo esta decisión con una mini-matriz coste-riesgo: si RTO ≤ 1–2 min y el negocio lo exige, activo-activo suele ser inevitable; si RTO de 10–15 min sirve, activo-pasivo bien ejercitado da un ROI excelente.

Georedundancia, GSLB y cambios de zona/región

- GSLB / DNS inteligente: enruta tráfico lejos del fallo; health checks externos.

- Multi-AZ primero, multi-región si el riesgo lo pide (regulatorio, desastres grandes).

- Datos: analiza latencias de replicación (síncrona vs asíncrona). Si tu checkout no tolera pérdida, acota RPO a segundos con enlaces de baja latencia o diseña “escrituras locales + reconciliación”.

Backups + replicación: estrategia combinada y pruebas de restauración

- Replicación cubre disponibilidad; backups cubren corrupción humana o lógica.

- Política sana: 3-2-1 (tres copias, dos soportes, una offsite), cifrado, retenciones y pruebas de restauración calendarizadas. En mis equipos, fallar una prueba de restore rompe el build: preferimos “avergonzarnos” en staging antes que en producción.

Operativa SRE: observabilidad, testeo y simulacros de desastre

La resiliencia no es un diagrama bonito, es disciplina operacional.

- Observabilidad con propósito: métricas (SLO), logs con contexto y trazas distribuidas.

- Alertas por síntoma, no por ruido: latencia p95, saturación de colas, tasa de errores; evita alertas por CPU aislada.

- Pruebas de carga y caos: genera picos controlados, desconecta una AZ en staging, corta una dependencia y mira si el sistema se degrada o se hunde.

- Postmortems blameless: aprender > culpar; cada incidente deja una automatización nueva.

Runbooks, automatización e IaC para “menos manos-teclado”

- Runbooks versionados: comandos, verificaciones, criterios de éxito y reversión.

- Bots de operación: ejecutar failovers, pausar colas, elevar límites.

- Infraestructura como código (IaC): que el estado de producción tenga receta; cero cambios “a mano”.

Checklist de auditoría de resiliencia (lista rápida)

- SLO/SLI definidos y visibles para todos

- RTO/RPO por dominio con responsables

- Modo degradado documentado y probado

- Backups con restores verificados mensualmente

- Simulacro de AZ caída trimestral

- Alertas por síntoma; on-call rotativo claro

- Runbooks actualizados; automatizaciones de tareas repetidas

- Revisiones de dependencias externas (SLA y límites)

Caso práctico: cómo reaccionar en 15 minutos ante un fallo total

Escenario: el primario de base de datos muere y el sitio empieza a lanzar 500. Objetivo: RTO 15 min, RPO ≤ 1 min.

Minuto 0–3 — Detección y contención

- Alertas por tasa de errores + latencia p95.

- Activar modo degradado: lee de caché, pausa operaciones pesadas, activar “read-only” si aplica.

- Comunicar en status page: “Degradación parcial, investigando”.

Minuto 3–7 — Diagnóstico y decisión

4. Health checks confirman caída del primario; réplicas sanas.

5. Decide failover (si réplicas válidas) o restore (si corrupción).

6. Congelar despliegues; asignar roles: incident commander, comms, executor.

Minuto 7–12 — Ejecución automatizada

7. Bot ejecuta failover a la réplica en otra AZ/región; invalida caché inconsistente.

8. GSLB/DNS ajusta tráfico; balanceadores saneados.

9. Validar integridad de datos con checksum y tests mínimos de negocio (login, checkout).

Minuto 12–15 — Verificación y cierre provisional

10. SLI vuelven a verde; levantar modo degradado gradualmente.

11. Comunicar recuperación y acciones siguientes.

12. Crear ticket para root cause y automatización que evite repetir el manual.

Lo crucial aquí no fue la potencia de la máquina, sino la confianza en que el sistema reacciona solo y el equipo sabe qué botón apretar si hace falta.

La resiliencia no es un parche, es diseño desde el inicio

Sistemas que “no fallan” no existen; sistemas que fallan bien sí. Yo lo resumo así: decide tus objetivos (SLO, RTO, RPO), duplica con inteligencia lo que de verdad importa, diseña degradaciones elegantes y automatiza la recuperación. Todo lo demás son slides bonitas. La nube deja de ser potencia para convertirse en confianza cuando, ante el peor día, el usuario apenas lo nota.

FAQs

¿Resiliencia es lo mismo que HA?

No. HA busca estar “siempre arriba”; resiliencia asume fallos y garantiza que el servicio siga de alguna forma y se recupere rápido.

¿Qué priorizo si tengo poco presupuesto?

Define SLO y RTO/RPO realistas; multi-AZ en DB y LB, backups con restore probado y un modo degradado claro. Eso solo te da un salto enorme.

¿Cómo sé si activo-activo me compensa?

Si el negocio exige RTO ~0 y tus datos toleran replicación de baja latencia, sí. Si puedes vivir con 10–15 minutos y priorizas simplicidad, activo-pasivo bien practicado es mejor.

¿Cada cuánto probar failover/restore?

Failover: trimestral (al menos). Restore: mensual. Lo que no pruebas, no tienes.

Opinión Personal

La nube me enseñó una verdad incómoda: la potencia no compra confianza. Puedes montar CPUs de última generación, discos NVMe en RAID y redes a 100 Gbps; el día que algo falle —y va a fallar— lo único que importa es cómo responde tu arquitectura. Por eso, para mí, la resiliencia no es un atributo técnico más: es una postura. Un sistema que presume de músculo pero entra en pánico ante el primer tropiezo es, en el fondo, un castillo de arena con luces LED.

Suele incomodar cuando digo que la pregunta correcta no es “¿cómo evito que algo falle?”, sino “¿qué tan rápido sigo dando servicio cuando falle?”. Parece una rendición, pero es lo contrario: es un compromiso con la realidad. Nadie opera en un laboratorio perfecto. Hay discos que mueren, zonas que se caen y personas —brillantes, humanas— que se equivocan. El mérito no está en prometer un 100% imposible, sino en diseñar para el peor día y llevarlo con elegancia.

He visto arquitecturas que se declaran “resilientes” por tener todo duplicado. Error. Duplicar sin criterio es como comprar dos paracaídas sin revisar el arnés: más caro, igual de frágil. La resiliencia inteligente elige con frialdad qué duplicar (DB, balanceadores, almacenamiento crítico) y qué dejar en modo “best effort” porque el impacto real es bajo. Esto no es tacañería; es responsabilidad. Alinear RTO, RPO y SLO con el negocio debería ser tan normal como versionar el código. Si no sabes cuántos minutos de caída tolera tu checkout —o cuántos datos puedes perder sin drama— no estás haciendo ingeniería; estás apostando.

También defiendo a muerte la degradación elegante. Lo binario (o todo, o nada) suena firme pero rompe carísimo. Prefiero un servicio que, en crisis, se declare “read-only”, recorte funcionalidades, sirva caché o encole cargas pesadas. A los usuarios les molesta menos un recorte temporal y honesto que un error 500 que huele a incendio. Y sí, esto exige diseño previo: circuit breakers, timeouts razonables, feature flags y rutas de escape claras. Si tu única estrategia es “reiniciar hasta que funcione”, no tienes resiliencia; tienes esperanza con cron.

Sobre automatización, confieso que soy fundamentalista. Cada intervención manual que se repite en un incidente es una deuda técnica que merma tu próxima madrugada. Los sistemas que “fallan bien” recuperan solos: health checks que importan, auto-healing real, playbooks ejecutables por un bot y IaC que deja rastro. ¿Romántico arreglarlo a mano a las tres de la mañana? Puede. ¿Escalable? Jamás. El trabajo heroico no construye confianza; la previsibilidad sí.

Y ahora, lo impopular: activo-activo no es el santo grial. Es tentador por el RTO casi cero, pero encarece, complejiza y, mal entendido, abre flancos nuevos (consistencia, latencia, reconciliación). Si tu negocio acepta 10–15 minutos de recuperación, un activo-pasivo disciplinado —ensayado, con monitoreo y conmutación probada— ofrece un ROI difícil de superar. La madurez no es elegir la opción más cara, sino la que mejor alinea riesgo y valor.

Hay un aspecto cultural que me parece tan crítico como los diagramas: los equipos que tratan la resiliencia como una práctica continua ganan. Observabilidad centrada en síntomas, simulacros periódicos (sí, “romper” cosas en staging), postmortems sin culpas y métricas visibles para todos. La resiliencia, cuando es real, deja huella: menos sorpresas, menos pánico, más conversaciones serenas en medio del caos. Cuando ocurre un incidente y el equipo habla en procedimientos y no en opiniones, sabes que estás del lado correcto.

¿Y la comunicación? Subestimada. Un buen status page, mensajes claros y expectativas honestas son parte de la resiliencia. Porque no se trata solo de mantener procesos vivos; se trata de preservar la confianza de quien te usa y de quien te paga. He visto incidentes técnicamente impecables arruinar la relación con clientes por silencio o eufemismos. Preferiría mil veces un “estamos en modo degradado; su pedido está a salvo y volveremos a la normalidad en 12 minutos” a un “algunas funcionalidades podrían verse afectadas” que no dice nada.

Al final, la resiliencia es una ética de trabajo aplicada a la tecnología: aceptar el fallo, acotar el daño, recuperarse solo y aprender siempre. No hay gloria en negar la entropía. La hay en dominarla lo suficiente como para que el usuario ni la note. El día que tu sistema afronta su peor caso y el soporte no explota, ese día la nube deja oficialmente de ser “potencia” para convertirse en confianza. Y esa, para mí, es la única métrica que merece un aplauso.

¿Tú cómo lo ves?

¿Has vivido un incidente que te cambió la forma de diseñar? ¿Activo-activo te ha merecido la pena o te pasaste a activo-pasivo con buenos simulacros? ¿Qué patrón de degradación te ha salvado la noche? Déjame tus comentarios abajo: quiero leer tus batallas, tus aprendizajes y —por qué no— tus herejías favoritas contra el “siempre arriba”.